ملف robots.txt | ما هي فائدته وكيف يعمل؟

ملف robots.txt

هل سمعت يوماً عن ملف robots.txt وتساءلت عن كيفية استخدامه على مواقع الووردبريس؟ الإجابة هي، أن معظم المواقع تحتوي على ملف robots.txt، لكن هذا لا يعني أن كل مالكي المواقع يتمكنون من فهمه واستخدامه بشكل سليم.

لكن من خلال هذا المقال، سوف نتمكن من تغيير هذا الأمر، حيث أننا سنشرح لك كافة التفاصيل التي تحتاج لمعرفتها حول ملف robots.txt.

فعلى سبيل المثال، ستعرف كيفية التحكم والتقليل من الدخول إلى موقعك باستخدامه بالإضافة إلى الكثير من الأمور الأخرى التقنية التي يمكنك تطبيقها باستخدامه.

ما هو ملف robots.txt ؟

قبل البدء في التحدث عن ملف robots.txt، من المهم أن تعرف معني كلمة “روبوت” في هذه الحالة.

الـ Robots هي أي نوع من البوتات التي تزور المواقع الالكترونية على الانترنت. والمثال الأوضح للبوتات أنها هي زواحف محركات البحث.

وتقوم هذه البوتات والتي تسمى زواحف (Crawlers) بالزحف على مواقع الويب لمساعدة محركات البحث مثل Google في فهرسة محتوى المواقع وترتيب بلايين الصفحات في نتائج البحث على الانترنت.

وبالتالي، فإن البوتات بشكل عام هي أمر هام جداً ومفيد بالنسبة للانترنت. لكن هذا لا يعني أنك أو غيرك من مشرفي المواقع سوف تفضلون حركة البوتات بصورة غير مقيدة حول المواقع.

وقد أدت هذه الرغبة في التحكم في كيفية تعامل الروبوتات مع المواقع الإلكترونية إلى تصميم معيار أو بروتوكول استبعاد الروبوتات (Robots exclusion standard) في منتصف التسعينات.

ويعتبر ملف robots.txt ووردبريس هو التطبيق العملي لهذا المعيار أو البروتوكول، فهو يسمح لك بالتحكم بكيفية تعامل البوتات مع موقعك.

وأصبح بإمكانك بسهولة من خلاله حظر البوتات المشاركة (Participating bots) بشكل كامل عن الموقع والتقليل من إمكانية دخولهم إلى مناطق محددة في موقعك وأكثر من ذلك.

إن تعبير البوتات المشاركة أو Participating bots هام أيضاً، حيث أن ملف robots.txt لا يستطيع اجبار كل البوتات على اتباع تعليماته بشكل كامل. والبوتات الخبيثة تستطيع وسوف تقوم بمخالفة تعليمات ملف robots.txt ووردبريس.

والأكثر من ذلك، هو أن حتى المنظمات ذات السمعة الجيدة تقوم في بعض الأحيان بتجاهل بعض التعليمات التي تضعها في ملف robots.txt.

و على سبيل المثال، تقوم Google بتجاهل كل القواعد التي قد تضعها في ملف robots.txt حول تحديد عدد المرات التي تزحف بها الزواحف على موقعك.

هل تحتاج إلى وجود ملف robots.txt داخل موقعك؟

إذا لم يكن لديك ملف robots.txt على موقعك، فإن محركات البحث ستبدأ في الزحف وفهرسة موقعك، ومع ذلك، فإنك لن تتمكن من تحديد الصفحات والمجلدات التي لا تريد أن يتم الزحف إليها وفهرستها.

وهذا الأمر لن يكون له تأثير كبير على الموقع أو المدونة إذا كانت لا تزال جديدة ولا تحتوي على الكثير من المحتوى.

ولكن الأمر سيختلف تماماً بعد أن يكبر موقعك أكثر ويحتوي على الكثير من المحتوى، حيث أنك ستحتاج إلى التحكم في عملية الزحف على الموقع وفهرسة محتواه.

والسبب في ذلك، أن بوتات البحث تحدد عدد مرات الزحف لكل موقع، وهذا يعني أنها تقوم بالزحف على عدد معين من الصفحات في المرة الواحدة.

وإذا لم ينتهي الزحف على كل الصفحات بالموقع، فإن البوتات ستتجه مرة أخرى للزحف على باقي صفحات الموقع، وهذا قد يؤثر بشكل كبير على معدل الفهرسة وسرعته.

ويمكنك التخلص من هذه المشكلة عن طريق منع بوتات البحث من محاولة الزحف على الصفحات الغير هامة مثل: Admin pages، ملفات الإضافات ومجلدات القوالب.

وبالتالي ستتمكن من توفير الكثير من عدد مرات الزحف المخصصة لموقعك، إذا قمت بحظر الزحف على الصفحات الغير هامة كتلك التي ذكرناها.

وهذا يساعد محركات البحث على الزحف على صفحات أكثر على موقعك وفهرستها بأسرع وقت ممكن.

و أحد الأسباب الأخرى الهامة التي سوف تدفعك لاستخدام ملف robots.txt، هو في حالة إذا كنت تريد حظر محركات البحث من فهرسة صفحة أو منشور ما على موقعك.

وعلى الرغم من أن هذه الطريقة هي ليست أكثر طريقة آمنة لـ حجب محتوى ما من الوصول إلى العامة، لكنها ستساعدك في منع هذا المحتوى من الظهور في نتائج البحث.

ما هو الشكل المثالي لملف robots.txt على الووردبريس؟

يستخدم العديد من المدونين الشهيرين ملف robots.txt بسيط جداً. وبالطبع يختلف محتواها، مع اختلاف احتياجات كل موقع بالتحديد:

| 1

2 3 4 |

User-agent: *

Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml |

هذه الصورة من ملف robots.txt تسمح للبوتات بفهرسة كل المحتوى وتوفر لهم رابط يشير إلى خريطة الموقع XML Sitemap.

وننصح باستخدام هذه القواعد في ملف robots.txt لمواقع الووردبريس:

| 1

2 3 4 5 6 7 8 |

User-Agent: *

Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml |

تقوم هذه القواعد بإخبار بوتات البحث بفهرسة كل الملفات والصور الموجودة على الووردبريس، وتمنعها من فهرسة ملفات الإضافات، ولوحة تحكم الووردبريس، و ملف readme وروابط الأفلييت.

وإذا قمت بإضافة خريطة الموقع إلى ملف robots.txt، سوف تجعل من السهل على بوتات Google البحث عن كل الصفحات على موقعك.

لماذا عليك الإهتمام بملف Robots.txt؟

بالنسبة إلى معظم مشرفي المواقع، تقتصر أهمية البنية الجيدة لملف robots.txt على قسمين، وهم:

- تحسين مصادر زحف محركات البحث عن طريق إعطاء أوامر لهم بعدم تضييع الوقت في الزحف إلى الصفحات التي لا تريد فهرستها، وهذا يساعد في التأكد من أن محركات البحث تركز على الزحف إلى الصفحات ذات الأهمية الأكبر بالنسبة لك.

- تحسين استخدام الخدمة عن طريق حظر البوتات التي تقوم بتضييع المصادر.

استخدامات ملف robots.txt لا تتخصص في التحكم بفهرسة الصفحات، ولكن كيف؟

إن ملف robots.txt ليس الطريقة السهلة والمضمونة الوحيدة للتحكم بالصفحات التي تقوم محركات البحث بـ فهرستها، فإذا كان هدفك الأساسي من استخدامه هو منع صفحات معينة من الظهور في نتائج محركات البحث، إذاً فإن الوسيلة الأفضل لفعل ذلك هو noindex tag أو أي وسيلة أخرى مباشرة ومشابهة لها.

وهذا يحدث بسبب أن ملف robots.txt لا يخبر محركات البحث بشكل مباشر بعدم فهرسة المحتوى، ولكنه يخبرها فقط بعدم الزحف عليها.

وبخصوص هذا الأمر، وفي حين أن Google لن تزحف على المحتوى الذي قمت بتحديده داخل الموقع، فقد قالت Google بنفسها أنه إذا أشار موقع خارجي إلى صفحة قمت باستبعادها من ملف robots.txt، فمن المحتمل أن جوجل ستقوم بـ فهرستها أيضاً.

إرشادات مشرفي المواقع حول التحكم بفهرسة الصفحات:

قد أكد John Mueller أيضاً على هذا الكلام السابق وهو أحد محللي الويب ماستر الشهيرين، وقال أنه في حالة وجود بعض الروابط التي تشير إلى صفحة ما، حتى وإن كانت هذه الصفحة محظورة من قبل ملف robots.txt، فـ قد يتم فهرستها أيضاً.

ومن الأشياء الهامة الأخرى التي يجب عليك معرفتها بخصوص هذا الأمر، هو أنه إذا كانت هذه الصفحات محظورة عن طريق ملف robots.txt، إذاً من الممكن أن يقوم أحد المستخدمين بإرسال روابط إلى واحدة من هذه الصفحات بشكل عشوائي.

وإذا حدث هذا الأمر فمن الممكن أن تتم فهرسة هذا العنوان بدون أي محتوى، نظراً لأنه محظور من قِبل ملف robots.txt. وهذا لأن محركات البحث لن تفهم أنك لا تريد فهرسة هذه الصفحات.

وإذا لم تقم بحظر هذه الصفحات باستخدام ملف Robots.txt يمكنك وضع noindex meta tag في هذه الصفحات.

وإذا حدث وأرسل أي من المستخدمين روابط إلى هذه الصفحات، وقامت محركات البحث بالزحف على هذا الرابط (نظراً لاحتمال وجود محتوى هام في هذا الرابط)، ستعرف بوتات الزحف أن هذه الصفحات لا تحتاج إلى أن يتم فهرستها وسوف تقوم بتخطيها ببساطة.

إذاً فإن الخلاصة بخصوص هذا الأمر، أنه إذا كانت لديك صفحات لا تريد أن يتم فهرستها، لا تستخدم أمر Disallow لتقوم بحظرها عن بوتات الزحف، ولكن استخدم noindex meta tag بدلاً منها لمنع فهرستها بالكامل.

والآن وبعد أن عرفت الإجابات بالتفصيل عن الأسئلة السابقة، حان الوقت لمعرفة كيفية انشاء ملف robots.txt على مواقع الووردبريس:

انشاء ملف robots.txt على الووردبريس:

يوجد 3 طرق مختلفة لإنشاء ملف robots.txt على الووردبريس، ويمكنك ببساطة اختيار الطريقة التي تفضلها وتطبيقها على موقعك:

الطريقة الأولى: تعديل ملف robots.txt باستخدام Yoast SEO:

إذا كنت من مستخدمي إضافة Yoast SEO لإنشاء ملف robots.txt، فعليك أن تعلم إنها تكون مزودة تلقائياً بمولد لـ ملف robots.txt، وبالتالي يمكنك استخدامها بسهولة وبشكل مباشر لإنشاء وتعديل الملف من لوحة تحكم الووردبريس، ولفعل ذلك اتبع الخطوات التالية:

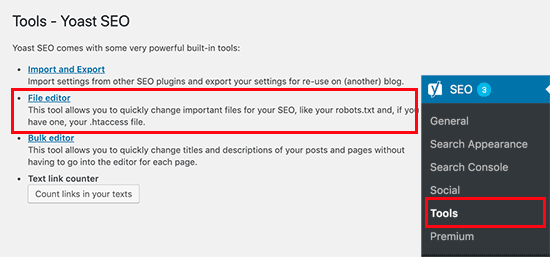

انقر على قسم “SEO” الموجود في الشريط الجانبي لـ لوحة تحكم الووردبريس واختر “Tools” من القائمة الجانبية التي ستظهر لك.

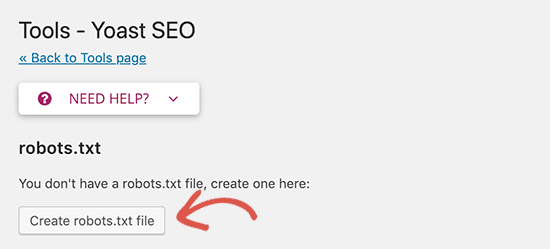

في الصفحة التالية، سوف يُعرض أمامك ملف robots.txt الموجود حالياً على الموقع. وإذا لم يكن هذا الملف موجوداً على الموقع، سوف تقوم إضافة Yoast SEO بتوليده أوتوماتيكياً.

وسوف يتم إضافة القواعد التالية إلى الملف robots.txt أوتوماتيكياً عند توليده باستخدام إضافة Yoast SEO:

| 1

2 |

User-agent: *

Disallow: / |

ولا بد أن تقوم بمسح هذا النص لأنه يقوم بحظر كل محركات البحث من الزحف على موقعك.

وبعد مسح هذا النص التلقائي، يمكنك إضافة القواعد التي تريدها إلى ملف robots.txt، وننصحك باستخدام صيغة ملف robots.txt المثالية التي تحدثنا عنها سابقاً في هذا المقال.

وفي النهاية، لا تنس حفظ ملف robots.txt عن طريق النقر على زر “Save robots.txt file”.

الطريقة الثانية: تعديل ملف robots.txt يدوياً باستخدام FTP:

إذا كنت تريد انشاء وتعديل ملف robots.txt باستخدام هذه الطريقة، يجب عليك إذاً استخدام إحدي برامج التعامل مع الـ FTP، وذلك كالتالي:

أولاً، سجل الدخول إلى حسابك على استضافة الموقع باستخدام الـ FTP.

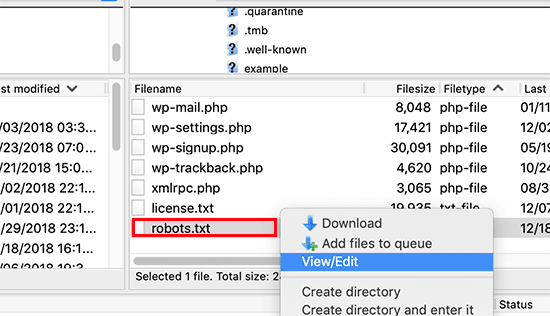

وبمجرد تسجيل الدخول ستتمكن من إيجاد ملف robots.txt في المجلد الرئيسي لموقعك على الووردبريس.

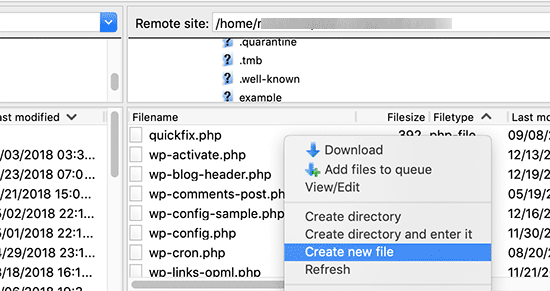

وإذا لم تجده في المجلد الرئيسي، فمن المحتمل أن ليس لديك على الموقع هذا الملف، وفي هذه الحالة قم بانشائه، وذلك الأمر لن يحتاج إلى الكثير من الوقت.

ملف robots.txt هو ملف نصي عادي، وهذا يعني أنه يمكنك تحميله على جهاز الكمبيوتر وتحريره باستخدام أي برنامج من برامج التحرير مثل Notepad و TextEdit.

وبعد أن تقوم بحفظ التغييرات على الملف، قم برفعه إلى الملف الرئيسي لموقعك بكل سهولة (Root folder).

الطريقة الثالثة: إنشاء وتعديل ملف robots.txt باستخدام All In One SEO:

تعتبر All in one SEO إضافة شهيرة مثل إضافة Yoast SEO، وإذا كنت تستخدمها فسوف تتمكن من تعديل وإنشاء ملف robots.txt مباشرة من واجهة الإضافة.

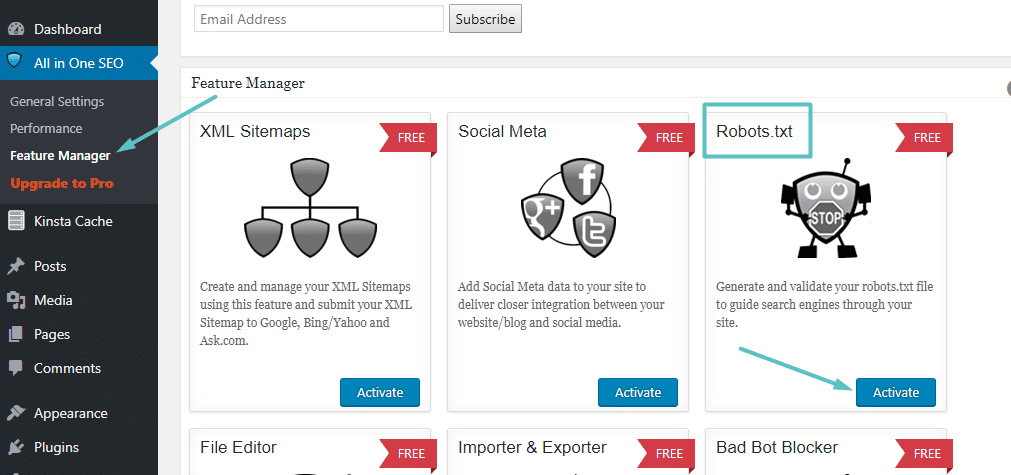

وكل ما تحتاج إلى فعله هو الذهاب إلى All in One SEO واختيار Feature Manager ثم تفعيل ملف robots.txt كما هو موضح في الصورة التالية:

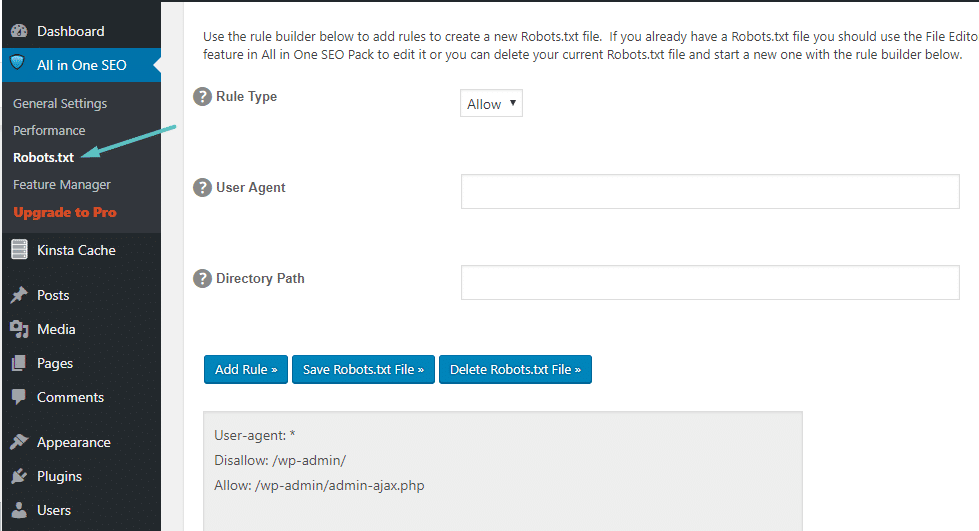

وبعدها، ستتمكن من التحكم في ملف robots.txt الخاص بموقعك عن طريق الذهاب إلى اختيار All in One SEO والنقر على Robots.txt، كما هو موضح لك في الصورة:

الأوامر التي يجب إضافتها إلى ملف Robots.txt:

الآن، وبعد أن قمت بإنشاء الملف بنجاح على الخادم المستضيف لموقعك، أصبح بإمكانك إجراء كافة التعديلات التي تحتاجها عليه.

لكن السؤال المهم هنا، ما هي الوظيفة الأساسية لهذا الملف؟ وماذا تفعل به؟ حسناً، كما عرفت من الجزء الأول من هذا الموضوع أن فائدة هذا الملف تكمُن في أنه يمكنك من التحكم في كيفية تعامل الروبوتات مع موقعك.

ويمكنك فعل ذلك من خلال أمرين أساسيين، وهما:

- User-agent: وهذا الأمر يمكنك من استهداف بوتات محددة، حيث أن User-agents هو ما يستخدمه البوتات للتعريف عن أنفسهم. ومن خلالهم يمكنك – على سبيل المثال – إنشاء قاعدة وتطبيقها على محرك البحث Bing وعدم تطبيقها على Google.

- Disallow: يمكنك هذا الأمر من إخبار الروبوتات بعدم الدخول إلى مناطق محددة من موقعك.

يوجد أيضا أمر ثالث وهو أمر “Allow” ولكنك ستحتاج إلى استخدامه في مواقف قليلة جداً، حيث أن كل شئ على موقعك محدد باختيار Allow تلقائياً، لذا لن تحتاج إلى استخدام أمر “Allow” في 99% من المواقف.

لكنه يجعل الأمر بسيطاً للغاية، في حالة إذا أردت استخدام أمر Disallow مع أحد المجلدات الرئيسية ومجلداته الفرعية لمنع الوصول إليه، واستخدام أمر Allow مع واحد من المجلدات الفرعية للسماح بالوصول إليه.

يمكنك إضافة القواعد إلى ملف robots.txt عن طريق تحديد القاعدة التي ستطبقها على أمر User-agent أولاً ثم تحديد القواعد التي ستقوم بتطبيقها باستخدام أمر Disallow و Allow.

ويوجد أيضاً بعض الأوامر الأخرى التي يمكنك تطبيقها مثل Crawl-delay و Sitemap، ولكن هؤلاء الأمرين إما:

- يتم رفضهما من قبل معظم الزواحف، أو يتم تفسيرهما بطرق مختلفة كثيرة (هذا في حالة استخدام أمر Crawl-delay).

- يتم رفضهما من قِبل أدوات مثل Google Search Console (بالنسبة إلى خريطة الموقع).

والآن، سنشرح لك ببعض الأمثلة لتعرف كيفية تطبيق هذه الأوامر على ملف robots.txt:

كيفية استخدام ملف robots.txt ووردبريس في حظر الوصول إلى الموقع بأكمله:

لنفترض أنك تريد منه كل الزواحف من الوصول إلى موقعك، وهذا بالطبع أمر غير محتمل حدوثه على أي موقع حي، لكن من الممكن أن تحتاج إلى تطبيقه في حالة المواقع المطوّرة.

ولفعل ذلك، أضف الكود التالي إلى ملف robots.txt على موقع الووردبريس خاصتك:

User-agent: *

Disallow: /

ولكن ماذا يعني هذا الكود؟

تعني علامة النجمة “*” الموجودة بجانب User-agent: “كل الـ user agents”.

أما علامة الخط المائل “/“ بجانب Disallow يعني أنك تريد حظر الوصول إلى كل الصفحات التي تحتوي على “yourdomain.com/” وهذا يعني كل صفحة على موقعك.

كيفية استخدام robots.txt في حظر بوتات معينة من الوصول إلى موقعك على الووردبريس:

والآن لنقم ببعض التغييرات، ولنفترض أنك لا تريد محرك البحث Bing أن يزحف على موقعك مرة أخرى وتريد فقط أن يقوم محرك البحث Google بالزحف على موقعك.

ولفعل ذلك قم بتغيير علامة النجمة “*” في الكود السابق واستبدالها بـ Bingbot، كما هو موضح في الكود التالي:

User-agent: Bingbot

Disallow: /

والكود السابق ينص بشكل أساسي على تطبيق أمر Disallow فقط على البوتات التي تستخدم Bingbot كـ User-agent.

وعلى الرغم من أنه غير محتمل أن تريد حظر بوتات Bing من الوصول إلى موقعك، إلا أن هذه الطريقة هي الأسهل إذا أردت منع أي محرك من محركات البحث من الوصول إلى موقعك.

كيفية استخدام Robots txt في حظر الدخول إلى مجلد أو ملف معين:

في هذا المثال، سوف نفترض أنك تريد فقط حظر الوصول إلى ملف أو مجلد معين، وأن هذا المجلد هو مجلد فرعي تابع لمجرد رئيسي ما.

وحتى تتمكن من تطبيق هذا الأمر على الووردبريس، سنفترض أنك تريد حظر:

- مجلد wp-admin بالكامل.

- و wp-login.php.

وفي هذه الحالة، يمكنك استخدام هذا الكود وتطبيق هذه الأوامر:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-login.php

كيفية استخدام Robots.txt للسماح بالوصول إلى ملف معين في مجلد محظور الوصول إليه:

والآن، لنفترض أنك تريد حظر مجلد بالكامل، لكنك لا زلت تريد الوصول إلى ملف معين داخل هذا المجلد. فإن أسهل طريقة لفعل ذلك هو أمر Allow، ويمكنك تطبيقه بسهولة على الووردبريس.

وفي الواقع، لقد نجح ملف robots.txt الإفتراضي على الووردبريس في توضيح هذا المثال وتبسيطه ببراعة، كما ستلاحظ في الكود التالي:

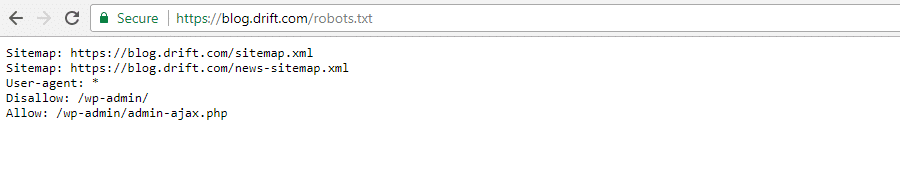

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

وهذه القصص (Snippet) تقوم بحظر الوصول إلى مجلد /wp-admin/ بأكمله ما عدا ملف /wp-admin/admin-ajax.php الموجود داخل هذا المجلد.

كيفية استخدام Robots.txt في منع البوتات من الزحف على نتائج بحث الووردبريس:

من أهم الأسباب التي ستجعلك تريد استخدام ملف robots.txt هو حظر البوتات من الزحف على صفحات نتائج البحث. يضيف الووردبريس العلامة “?s=“ تلقائياً إلى الملف، وبالتالي كل ما تحتاج إلى فعله هو إضافة القاعدة التالية:

User-agent: *

Disallow: /?s=

Disallow: /search/

قد تؤثر هذه الطريقة أيضاً بشكل كبير على أخطاء 404، إذا كانت تصل لك رسائل بهذه الأخطاء على الموقع.

كيفية إنشاء قواعد مختلفة لـ بوتات مختلفة في ملف Robots.txt:

حتى الآن، كل الأمثلة السابقة تتحدث عن تطبيق قاعدة واحدة من خلال ملف robots.txt. لكن ماذا إذا كنت تريد تطبيق أكثر من قاعدة مختلفة لأكثر من بوت؟

إذاً، يجب عليك بكل بساطة إضافة القاعدة التي تريدها إلى جانب أمر User-agent لكل بوت من بوتات الويب.

وعلى سبيل المثال، إذا كنت تريد تطبيق قاعدة واحدة على كل البوتات وتطبيق قاعدة أخرى مختلفة على بوت واحد فقط ولنفترض أنه Bingbot، سوف تحتاج إلى تطبيق القواعد التالية على ملف robots.txt:

User-agent: *

Disallow: /wp-admin/

User-agent: Bingbot

Disallow: /

والكود السابق يوضح لك، أنه سيتم حظر كل البوتات من الوصول إلى /wp-admin/، لكن سيتم حظر Bingbot من الوصول إلى موقعك بأكمله.

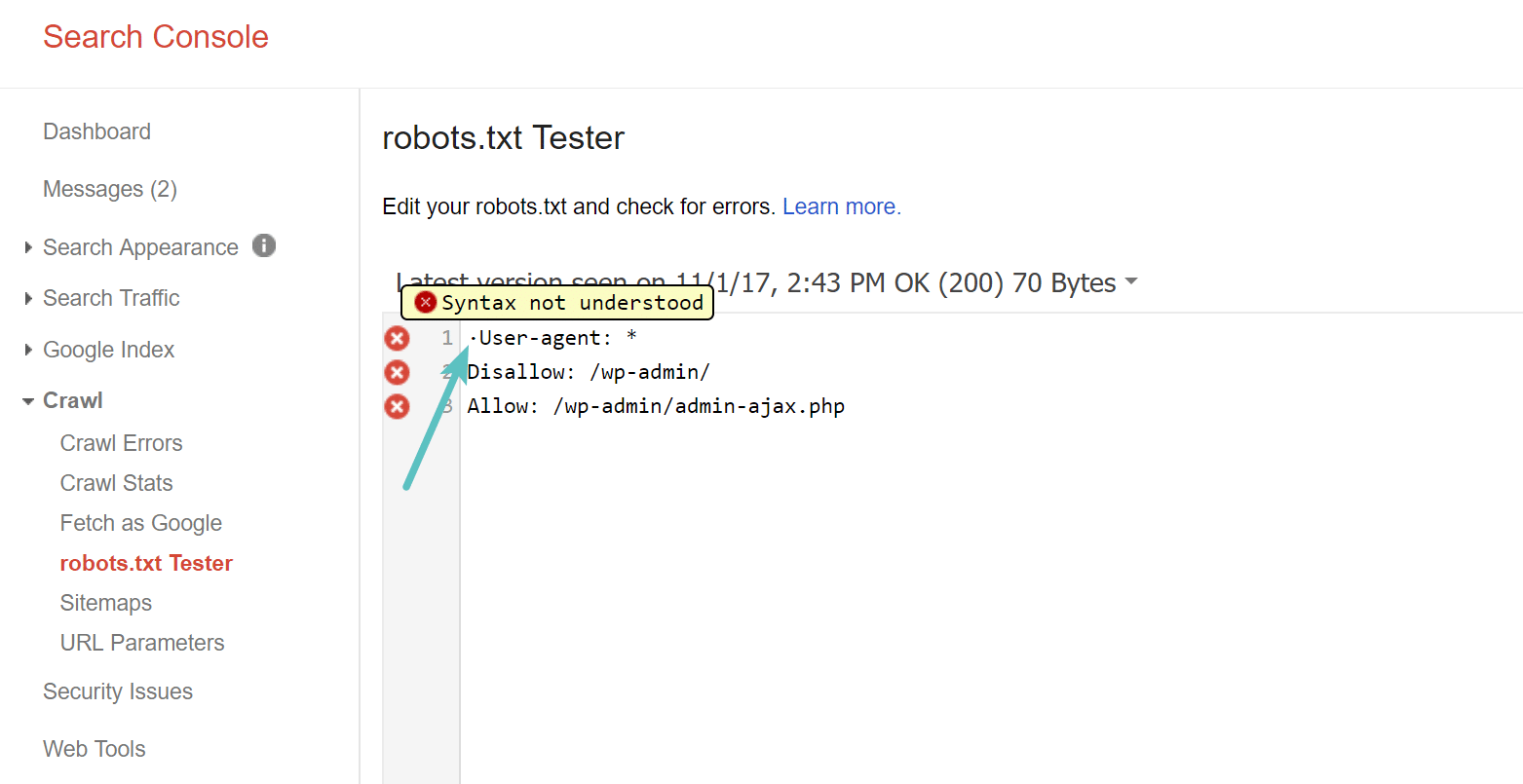

اختبار ملف Robots.txt على موقعك:

يمكنك اختبار ملف robots.txt ووردبريس في Google Search Console للتأكد من أنه تم إعداده بنجاح.

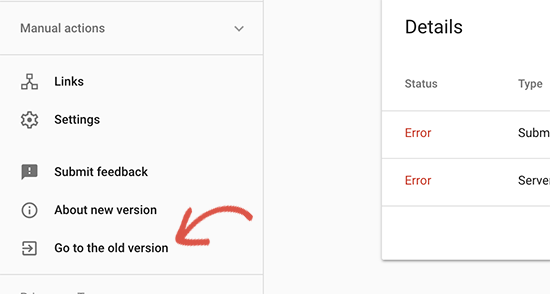

وذلك عن طريق بعض الخطوات البسيطة، افتح أولاً موقعك في Google Search Console عن طريق تسجيل الدخول بحسابك عليه، وحوله إلى النسخة القديمة من خلال النقر على “Go to the old version” كما هو موضح في الصورة.

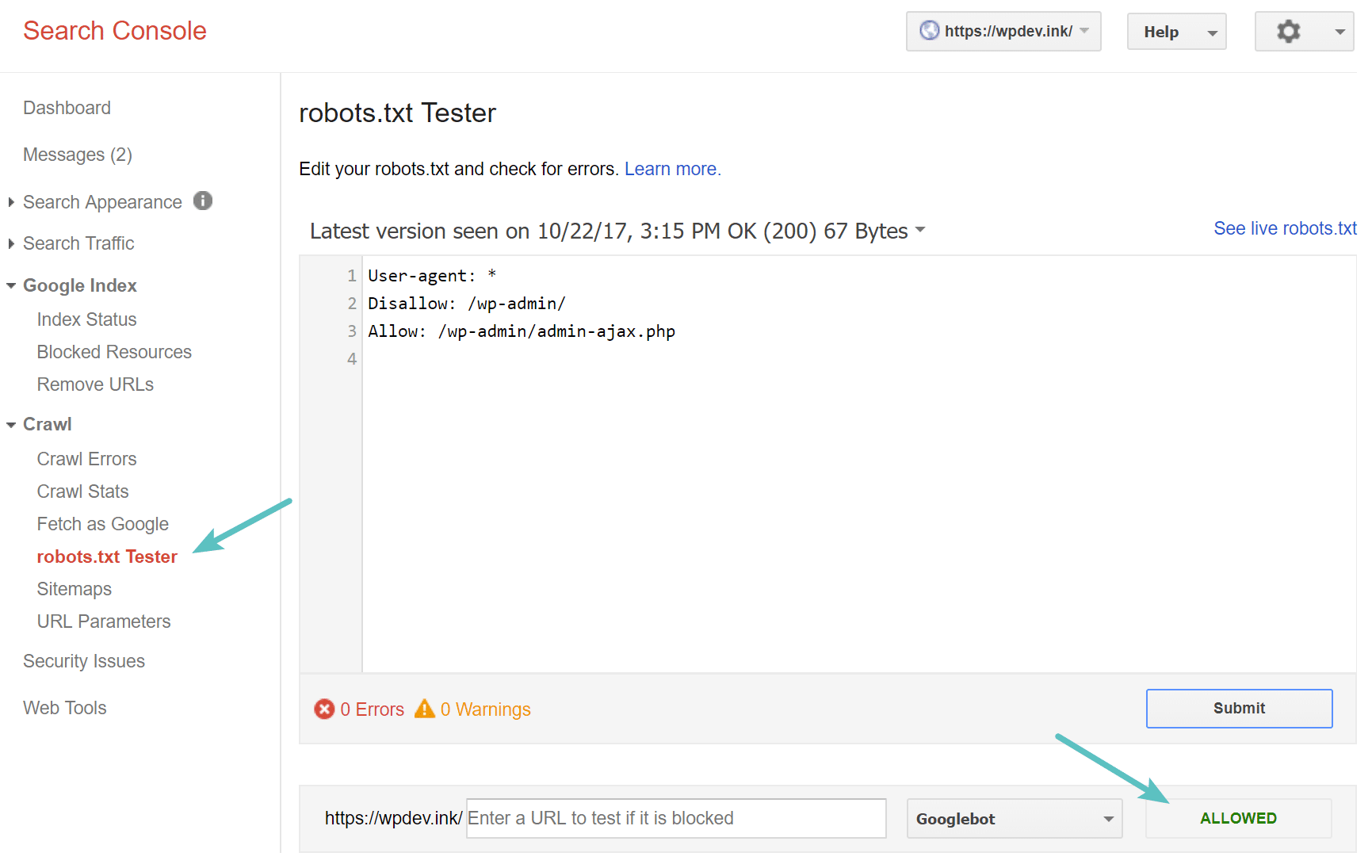

سوف يأخذك هذا إلى واجهة Google Search Console القديمة، ومنها يمكنك تشغيل أداة اختبار ملف robots.txt، عن طريق الخطوات التالية:

انقر على “robots.

txt Tester” الموجودة تحت قسم “Crawl” ، وبعدها قم بكتابة أي عنوان URL لموقعك، ومن ضمنهم عنوان الصفحة الرئيسية.

إذا كان مسموح لكل البوتات بالزحف على موقعك، سترى أن كل الإختيارات مظللة باللون الأخضر. يمكن أيضاً أن تقوم بإدخال عناوين الـ URL التي قمت بحظرها لتتأكد من أنها محظورة بالفعل.

احترس من UTF-8 BOM:

إن BOM هي اختصار لكلمة Byte Order Mark أي علامة ترتيب البايتات وهو حرف خفي، والذي يتم إضافته في بعض الأحيان إلى الملفات من قبل محرري النص القديمين.

وإذا حدث هذا الأمر على ملف robots.txt على موقعك، قد لا تتمكن Google من قراءته بشكل صحيح. ولهذا السبب، يجب أن تتحقق دائماً من وجود أي أخطاء في الملفات.

وعلى سبيل المثال، كما هو موضح في الأسفل، فإن الملف يحتوي على Character خفية و Google ترسل رسالة توضح أنها لا تتمكن من فهم تركيب الجملة “Syntax not understood”.

وهذا يتسبب في إبطال مفعول أول سطر في ملف robots.txt بشكل أساسي، وهذا أمر غير جيد على الإطلاق!

اهتمام Googlebot بالولايات المتحدة الأمريكية:

من الهام جداً أيضاً ألّا تقوم بحظر Googlebot عن الولايات المتحدة الأمريكية، حتى إذا كان الموقع يستهدف منطقة جغرافية أخرى خارجها.

فإن Googlebot يقوم في بعض الأحيان بالزحف على صفحات المواقع المحلية، لكن في الأساس يركز على الولايات المتحدة الأمريكية.

ما الذي يضعه مواقع الووردبريس الشهيرة في ملف Robots.txt؟

حتى تتمكن حقاً من تحقيق أقصى استفادة من النقاط المذكورة سابقاً في هذا الموضوع، إليك كيف يستخدم بعض المواقع الشهيرة على الووردبريس ملف robots.txt:

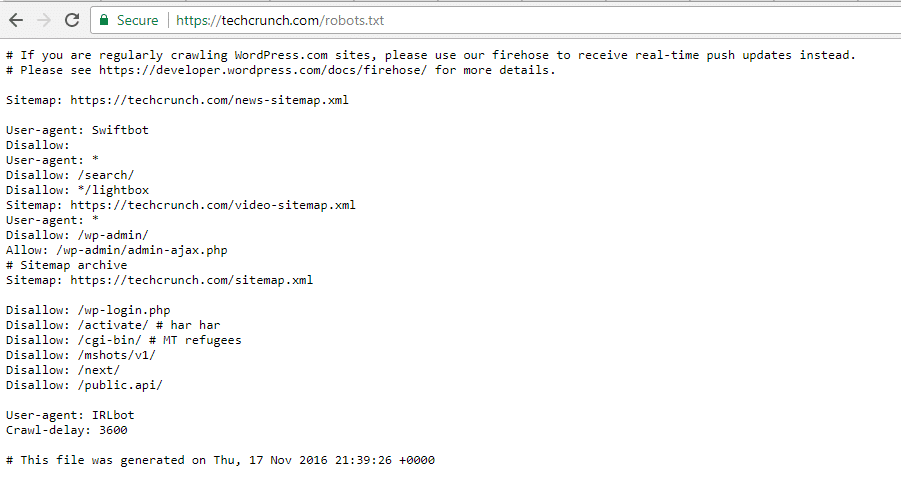

TechCrunch:

بالإضافة إلى إمكانية حظر الدخول إلى الكثير من الصفحات باستخدام robots.txt، إلّا أن TechCrunch يقوم وبشكل ملحوظ بحظر الزواحف من الوصول إلى:

- /wp-admin/

- /wp-login.php

يمكنك بـ استخدامه أيضاً وضع الكثير من القيود على البوتات التالية:

- Swiftbot

- IRLbot

وفي حال تساءلت عن ما هو IRLbot؟، فإنه زاحف لمشروع بحثي بجامعة Texas A&M.

The Obama Foundation:

لم تضف The Obama Foundation أي إضافات مميزة، ولكنها تعمل بشكل أساسي على تقنين الوصول إلى /wp-admin/.

Angry Birds:

يحتوي Angry Birds على نفس الإعدادات الخاصة بـ The Obama Foundation، ولا يوجد به أي شئ مميز.

Drift:

وفي النهاية، يختار Drift تعريف خريطة الموقع الخاصة به في ملف robots.txt ووردبريس، ولكن من ناحية أخرى فإنه يترك نفس الـ Restrictions التلقائية مثل The Obama Foundation و Angry Birds.

استخدام Robots.txt بالطريقة الصحيحة:

وفي حين أننا نقوم بتغطية كل المعلومات التي تخص ملف robots.txt، دعنا الآن نختصر الفكرة العامة لاستخدام هذا الملف بالشكل الصحيح.

أولاً، دعنا نذكرك مرة أخرى أن استخدام أمر Disallow في robots.txt لا يتشابه مع استخدام noindex tag، حيث أن ملف robots.txt يقوم بحظر الزحف على الصفحات التي تحددها، ولكنه لا يؤثر بالضرورة على فهرسة هذه الصفحات.

ومن أهم استخدامات هذا الملف هو إضافة قواعد معينة إلى الموقع لتحديد كيفية تعامل محركات البحث والبوتات مع محتوى الموقع، لكنه لن يتحكم بالضرورة بفهرسة هذا المحتوى من عدمه.

أما بالنسبة لمستخدمي الووردبريس الجدد، فإنهم لن يحتاجوا بالضرورة إلى تعديل ملف robots.txt الإفتراضي، ولكن إذا كانت لديك مشاكل محددة مع بوت معين أو تريد تحديد كيفية تعامل محركات البحث مع إضافة أو قالب معين تستخدمه على موقعك، فقد تحتاج وقتها إلى إضافة القواعد الخاصة بك.

الخلاصة:

في النهاية، نتمنى أن نكون قد تمكنا من توفير كل المعلومات التي تحتاجها حول ملف robots.txt، وأن تكون قد عرفت من خلال هذا المقال كيفية استخدامه والمواقف التي ستحتاج إلى استخدامه بها والقواعد التي يمكنك تطبيقها على موقعك من خلاله للـ تحكم بطرق تعامل محركات البحث والبوتات مع الموقع بشكل عام.

وإذا سمعت الأقاويل التي تنص على أن حظر بعض تصنيفات الووردبريس أو علامات التبويب أو الصفحات المؤرشفة يؤدي إلى تحسين معدل الزحف.

مما يؤدي إلى فهرسة محتوى الموقع بشكل أسرع وتحسين ترتيب الموقع في نتائج البحث، فتأكد من أنه لا يوجد صحة لأي من هذا الكلام، فهو بالتأكيد ضد إرشادات مشرفي المواقع.

وننصحك فقط باتباع التعليمات السابقة مع ملف robots.txt لتصل إلى أفضل النتائج مع بوتات محركات البحث.

اقرأ ايضاً:

اهم مبادئ السيو وتحسين مبادئ السيو.